Очистка и подготовка данных для ИИ: что делать, если у вас хаос в Excel и CRM

Подготовка данных — ключевой этап перед внедрением любых AI-инструментов в маркетинге. Рассказываем, как перейти от разрозненных CRM-выгрузок и Excel-файлов к устойчивому слою данных, на котором можно строить сквозную аналитику, атрибуцию и ИИ-оптимизацию. Рассмотрим типовые ошибки, архитектуру, шаги подготовки и реальные сценарии работы на очищенных данных.

Чтобы ИИ давал предсказуемый и понятный результат, нужен устойчивый слой данных: источники, согласованные справочники, единые идентификаторы, очищенные таблицы и витрины под задачи аналитики и моделей.

В этой статье — пошаговый план, как перейти от разрозненных CRM-данных и Excel-файлов к данным, которые можно безопасно использовать в ИИ-проектах. Материал ориентирован на CMO, Head of Analytics, Head of Digital и руководителей продуктовых команд.

Кратко: главное по теме

- Очистка и подготовка данных для ИИ — это регулярный процесс: сбор, очистка, консолидация, формирование витрин и контроль качества.

- Несогласованные данные из CRM, Excel и рекламных кабинетов ломают атрибуцию, искажают прогнозы и снижают доверие к дашбордам и ИИ-инструментам.

- Архитектура для ИИ в маркетинге строится вокруг контура передачи данных и опорных справочников: единые идентификаторы клиентов, сделок, кампаний и каналов.

- Практический план: сформулировать цели ИИ, сделать ревизию источников, выбрать опорные системы, выровнять справочники и идентификаторы, очистить данные, построить витрины и настроить контроль качества.

- Без назначенных владельцев данных и метрик качества даже хорошо спроектированная архитектура со временем теряет устойчивость.

- Решения CyberBrain реализуют важный принцип — единый управляемый контур данных с очисткой, консолидацией и витринами, за счёт чего компания может обойтись без долгой собственной разработки.

Что такое подготовка данных для ИИ в маркетинге

Подготовка данных для ИИ в маркетинге — это набор регулярных процессов, который превращает выгрузки из CRM, Excel, рекламных кабинетов и веб-аналитики в управляемый слой данных для отчётов и моделей.

Практически это выглядит так:

- Сбор данных — регулярная загрузка данных из CRM, веб-аналитики, рекламных платформ, коллтрекинга, офлайн-продаж.

- Очистка — удаление дублей, исправление форматов, устранение технических записей, фильтрация ботов и заведомых артефактов.

- Консолидация — соединение сущностей (клиент, сделка, лид, заявка) между системами и выравнивание статусов и справочников.

- Обогащение — добавление признаков: сегменты, когорты, маржа, LTV, статусы риска, продуктовая линейка.

- Витрины — таблицы и срезы под конкретные задачи: BI, дашборды, модели атрибуции, прогнозы, оптимизаторы.

- Мониторинг качества — автоматические проверки полноты, свежести и согласованности данных.

Задача этих шагов — обеспечить стабильный слой, на который можно опираться при принятии решений и запуске ИИ-сервисов.

Какие риски создают CRM и Excel для ИИ-проектов

Для CMO и руководителя аналитики ключевой вопрос — можно ли на основе текущих данных принимать решения о бюджетах, медиамиксе и продукте. Если данные не подготовлены, это влияет на каждый следующий шаг.

Типичные последствия:

- Атрибуция даёт искажённый результат. Разорванные цепочки web и app, дубли клиентов, некорректные статусы сделок приводят к неправильной оценке вкладов каналов и моделей атрибуции.

- ИИ-модели воспроизводят ошибки данных. Алгоритмы оценки качества лида, склонности к покупке или перераспределения бюджета ориентируются на те же перекосы, которые есть в исходных таблицах.

- Дашборды расходятся между собой. Трекер, рекламные кабинеты и CRM показывают разные значения. Команда тратит время не на поиск решений, а на обсуждение расхождений.

- Любое изменение схемы усложняется. Попытка обновить правила или логику отчёта превращается в пересборку множества Excel-файлов, которые никто не хочет трогать.

- Возникают риски по данным. Если выгрузки из CRM используются напрямую в внешних ИИ-сервисах, увеличивается вероятность передачи чувствительных данных за пределы контролируемого контура.

Когда компания переходит к управляемому контуру данных, основная выгода — предсказуемость: меньше ручных операций, меньше конфликтов цифр, ясное понимание, как формируются показатели в отчётах и моделях.

Как выглядит архитектура данных для ИИ в маркетинге

Технологический стек может отличаться, но логика архитектуры обычно схожая.

- Источники данных

- CRM и системы продаж

- Веб-аналитика

- Рекламные кабинеты

- Платформы рассылок и коллтрекинга

- Офлайн-продажи и call-центр

- Внутренние отчёты и выгрузки партнеров

- Контур передачи и обработки данных

- Забирает данные из источников по расписанию

- Приводит их к общему формату

- Выполняет первичные проверки качества

- Складывает данные в единое хранилище или аналитический контур

- Хранилище и витрины

- Слой сырых данных — в том виде, как они приходят из источников

- Рабочий слой — вычищенные таблицы с согласованными идентификаторами и справочниками

- Витрины под задачи: атрибуция, оценка инкрементальности, оптимизация бюджета, регулярная отчётность

- Прикладные сервисы и ИИ-уровень

- Отчёты и дашборды

- Сервисы атрибуции и оптимизации бюджета

- ИИ-ассистенты для маркетинга, продукта и аналитики

Важный принцип: модели и пользователи работают с витринами, а не с исходными выгрузками. Это снижает объём ошибок и упрощает поддержку.

Пошаговая инструкция: как выбраться из хаоса Excel и CRM

4.1. Определяем цели ИИ и ключевые метрики

Прежде чем что-то менять в данных, нужно ответить на вопрос, ради каких решений это делается. Для маркетинга и продукта это обычно:

- оценка вклада каналов и кампаний в выручку и заявки

- оптимизация распределения бюджета

- прогнозирование спроса и выручки

- помощь командам через ИИ-ассистентов

Для каждого сценария стоит заранее зафиксировать, какие метрики будут считаться опорными:

- CPA, CPL, CPO, ROMI / ROAS

- LTV и маржинальность

- статусы лидов и сделок

- шаги воронки — от первого касания до договора

Это позволяет понять, какие поля и сущности действительно критичны и с чего стоит начать очистку и консолидацию, не распыляясь на второстепенные данные.

4.2. Проводим ревизию источников и выбираем опорные системы

Дальше нужно сформировать понятную картину, где какие данные хранятся.

- Составьте список систем и файлов:

- CRM

- ERP или биллинг

- рекламные платформы

- веб-аналитика

- BI-отчёты и Excel-файлы, которые используются в отделах

- Для каждой сущности определите опорный источник:

- клиент и контактные данные

- лид и обращение

- сделка и финансовый результат

- рекламная кампания и ее структура

Опорный источник — система, в которой информация по этой сущности наиболее полная и актуальная.

- Оцените состояние данных:

- где концентрация дублей выше всего

- где расходятся статусы и суммы

- где вместо интеграции живут ручные Excel-файлы

Полезно собрать схему движения данных: какие шаги проходит клиент и как его путь разделяется между системами.

4.3. Выравниваем справочники и идентификаторы

Если одна и та же сущность по-разному называется и по-разному кодируется в разных системах, любая модель будет работать нестабильно.

Что важно сделать:

- Настроить справочники кампаний и каналов

- ввести шаблон именования кампаний

- определить список каналов и источников, который используют все участники процесса

- договориться, какие кампании объединяются в один канал, а какие ведутся отдельно

- Ввести единые идентификаторы клиентов и сделок

- выбрать, какие идентификаторы считаются основными: технический идентификатор пользователя в цифровой среде, идентификатор договора или сделки

- для web и app реализовать схему, где действия одного пользователя в браузере, приложении и CRM можно связать между собой

- Настроить связку онлайн и офлайн

- определить, по каким полям соединяются онлайн-поведение и офлайн-покупка: телефон, email, карта лояльности, номер договора

- унифицировать хранение этих полей в системах

После этого становится возможным строить цепочки касаний и считать показатели на уровне клиента, сделки, сегмента или кампании без постоянной ручной склейки.

4.4. Чистим и объединяем данные

Когда справочники и идентификаторы выровнены, можно переходить к очистке.

- Задайте правила качества для ключевых полей

- телефон: формат и длина

- email: корректность адреса и домена

- суммы: допустимые диапазоны

- статусы сделок: перечень допустимых значений

- Настройте поиск и объединение дублей

- определите комбинации полей для поиска дублей (телефон, email, ФИО, ИНН, название компании)

- опишите, какая система приоритетна по каждому полю при объединении

- Отфильтруйте технические записи и ботов

- используйте фильтры веб-аналитики

- заведите списки IP, доменов и user-agent, которые нужно исключить

- согласуйте набор правил между командами

- Определите глубину исторической корректировки

- выберите период, за который критично привести историю в порядок (например, год или полтора)

- примените правила очистки к этому периоду, чтобы модели и отчёты опирались на сопоставимые данные

Достаточно сфокусироваться на ключевых сущностях и полях — этого уже будет достаточно для первых ИИ-сценариев.

4.5. Строим витрины под задачи ИИ

Следующий шаг — собрать данные в удобную форму.

- Настройте слой хранения

- выберите хранилище, в котором будете вести рабочие таблицы

- организуйте загрузку очищенных данных из контура передачи в это хранилище

- Сформируйте витрины под задачи

- витрина для атрибуции: цепочки касаний с показами, кликами, визитами, заявками и сделками

- витрина для оптимизации бюджета: показатели по кампаниям и каналам (показы, клики, затраты, конверсии, выручка, маржа)

- витрина для ИИ-ассистента: срезы по продуктам, каналам, регионам, когортам, воронкам

- Оформите документацию

- опишите поля, их происхождение и назначение

- зафиксируйте частоту обновления

- определите, какие команды используют каждую витрину и для каких задач

С этого момента ИИ-модели и дашборды могут опираться на один и тот же набор данных, а не на частные выгрузки разных отделов.

4.6. Обеспечиваем безопасность

Работа с данными для ИИ всегда привязана к требованиям безопасности и комплаенса.

- Разделите контуры

- операционный контур — CRM и ERP для ежедневной работы

- аналитический контур — хранилище и витрины для отчётности

- ИИ-контур — витрины для моделей, где нет лишних персональных данных

- Проведите деперсонализацию

- замените персональные поля техническими идентификаторами там, где не нужен уровень отдельного клиента

- используйте агрегированные данные, если для задачи достаточно информации на уровне сегментов и когорт

- Настройте доступы

- определите роли и права для маркетинга, продукта, аналитиков, data-команды

- ограничьте возможность прямой выгрузки CRM-данных во внешние сервисы

- подключайте внешние модели через контролируемые интерфейсы

Так вы сможете использовать ИИ-инструменты без лишних рисков для данных клиентов и компании.

4.7. Настраиваем постоянный контроль качества

Даже хорошо выстроенная схема деградирует без мониторинга.

- Определите метрики качества

- полнота: доля записей с заполненными обязательными полями

- свежесть: задержка данных относительно регламента

- согласованность: насколько сходятся показатели между системами

- уникальность: доля дублей

- валидность: доля записей, проходящих проверки на формат и логику

- Настройте правила и уведомления

- задайте пороговые значения

- организуйте уведомления при отклонениях

- зафиксируйте, кто и в какие сроки отвечает за исправление

- Назначьте владельцев

- ответственных за справочники каналов, кампаний и статусов

- владельцев витрин

- владельца контура передачи и интеграций

Практические сценарии и примеры применения

Сценарий 1. Сквозная аналитика на едином слое данных

Пример: у компании несколько источников данных: сайт и приложение, CRM, партнёрские каналы, колл-центр, офлайн-точки. Заявки фиксируются в разных системах, статусы не совпадают, web и app живут отдельно, бюджетные выгрузки приходят в Excel. Отдельные отчёты показывают разную картину, и перед любым обсуждением результатов приходится заново собирать воронку вручную.

Когда идентификаторы и статусы приведены к одному виду, данные можно собирать в единый слой. Эту задачу полностью закрывает модуль сквозной аналитики Data Pipeline. Он подключает нужные источники — web, app, CRM, пост-клики, пост-просмотры, коллтрекинг — обновляет данные ежедневно, приводит их к общему формату вокруг client_id или crm_id и формирует готовые витрины. Воронка от первого контакта до продажи собирается без разрывов, web и app объединены, бюджеты и продажи синхронизированы. Команда работает с одной согласованной цифрой и получает инфраструктуру, которая подходит не только для сквозной аналитики, но и для атрибуции, прогнозов и других ИИ-сценариев дальше по цепочке.

Сценарий 2. Мультиканальная атрибуция на подготовленных цепочках касаний

Пример: компания работает одновременно с медийной рекламой, контекстом, ремаркетингом, партнёрскими источниками, приложением и офлайном. Клиент проходит через десятки касаний, но в отчётах они видны частично: что-то учитывается как последний клик, что-то — как показ, что-то теряется в CRM или дублируется. В такой конфигурации перформанс кажется сильнее, чем он есть, а влияние медийных кампаний доказать практически невозможно.

Когда цепочки действий клиента собраны полностью — web, app, post-click, post-view и офлайн-этапы — можно оценить вклад каналов по реальному участию в продаже. Атрибуция Шепли — лучший выбор для этой цели. Все собранные пути передаются в максимально точную и объективную модель на основе данных, которая рассчитывает вклад каждого канала, анализируя комбинации взаимодействий и их влияние на итоговый результат. Атрибуция считается ежедневно на полном объёме данных и не ограничена длиной цепочек, поэтому в отчётах появляется честный CPA и ROI для каждой кампании. Команда получает прозрачную картину эффективности медийных и performance-каналов и может распределять бюджеты по фактической доходности, а не по эвристикам и последнему клику.

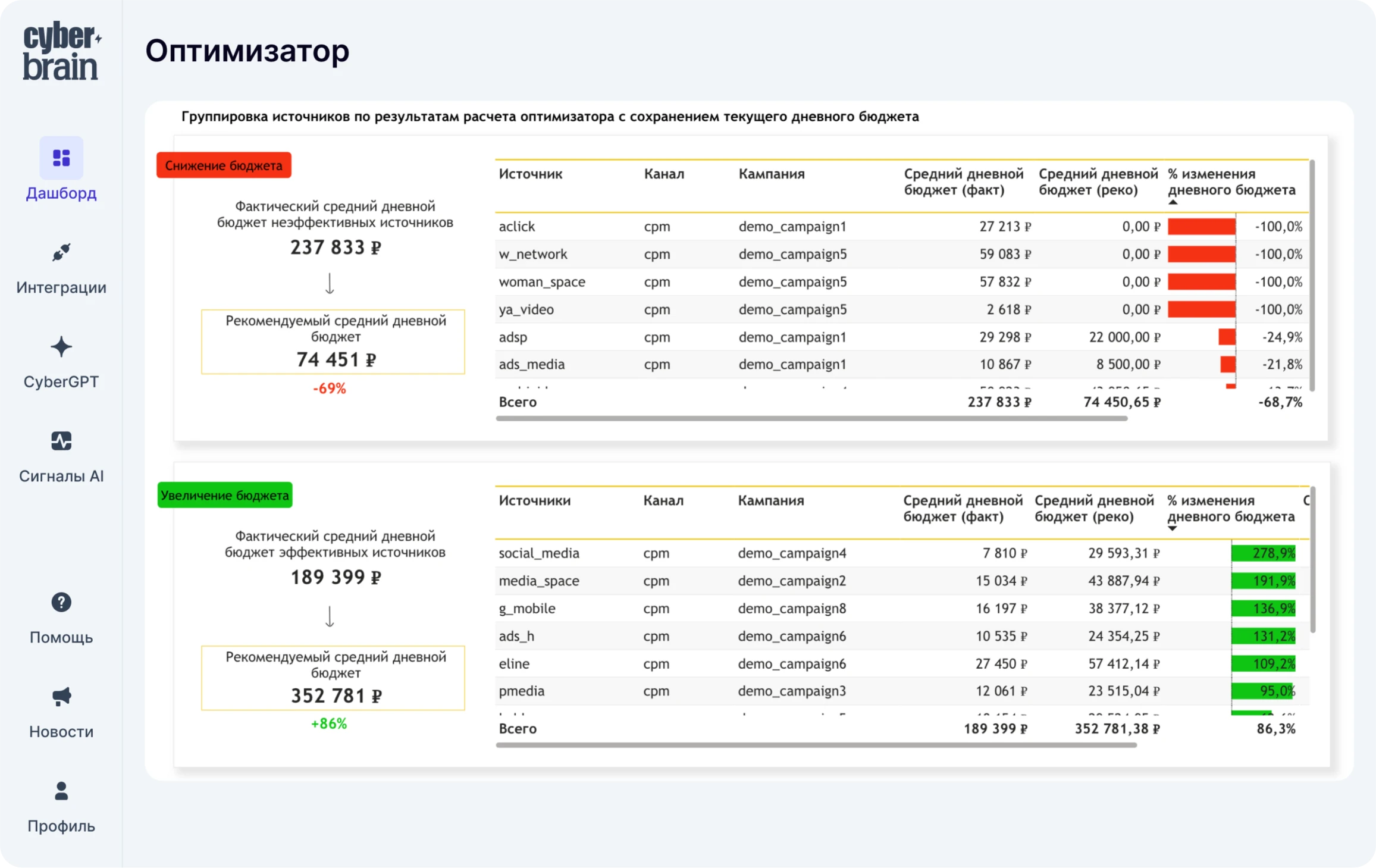

Сценарий 3. ИИ-оптимизация бюджета на согласованных показателях

Пример: крупный рекламодатель управляет десятками кампаний в нескольких каналах. Сквозная аналитика и атрибуция уже настроены, но бюджет всё ещё распределяется вручную: команда сверяет прошлые результаты, оценивает текущие метрики и раз в месяц корректирует план. При резких изменениях поведения аудитории или падении эффективности отдельных кампаний скорость реакции ограничена, и удерживать целевые CPA или ROMI становится трудно.

Когда показатели расходов, конверсий, продаж и маржинальности приведены к одному виду и собираются в единую витрину, можно подключать автоматизированное планирование. Оптимизатор CyberBrain перебирает сотни вариантов распределения бюджета по каналам и кампаниям, прогнозирует для каждого варианта CPA, ROMI, конверсии и доход, учитывает заданные ограничения и различия между медийными и performance-задачами. На выходе команда получает конкретные рекомендации по изменениям бюджета, основанные не на ручных расчётах, а на модели, которая оценивает влияние каждого варианта на ключевые метрики.

Типичные ошибки, ограничения и риски

- Запуск ИИ на текущих данных без подготовки

Модели обучаются на дублях, неполных и противоречивых данных. - Отсутствие владельцев данных

Никто не отвечает за справочники, витрины и метрики качества. Любое изменение в нейминге кампаний или статусов сделок приводит к поломке отчётов и моделей. - Упор на ручной Excel вместо контура передачи данных

Отчёты собираются вручную, при этом параллельно запускаются ИИ-проекты. Ошибки в формулах и разные версии файлов влияют на результат модели. - Игнорирование идентификаторов и связки web, app и offline

Попытки считать сквозную аналитику и атрибуцию без устойчивых идентификаторов приводят к потере части цепочек и неточным выводам. - Недооценка требований безопасности

Прямые выгрузки CRM в публичные ИИ-сервисы создают риск утечек и нарушений внутренних требований. - Отсутствие мониторинга качества

Ошибки в интеграциях, смена разметки или обновление инструментов попадают в данные и отчёты, но компания узнаёт о проблеме уже по факту влияния на результаты. - Попытка сразу привести в порядок все данные

Такой подход растягивается во времени и теряет приоритет. Гораздо эффективнее выделить один сценарий и слой данных под него, довести его до рабочего состояния и далее расширяться.

Как это реализовано в CyberBrain

Платформа CyberBrain создавалась вокруг задач сквозной аналитики и ИИ-оптимизации маркетинга, поэтому подготовка данных встроена в архитектуру решений.

FAQ по очистке и подготовке данных для ИИ

1. Как понять, что данные готовы для запуска ИИ-модели?

Смотрите на полноту заполнения ключевых полей, расхождения между системами по основным показателям, объём дублей и наличие согласованных справочников и идентификаторов. Если по этим пунктам всё хорошо, можно планировать пилот модели. Если нет, разумнее сначала вложиться в архитектуру и качество данных.

2. Обязательно ли доводить данные до идеала?

Нет. Важно, чтобы основные ошибки были выявлены и управлялись. Модели устойчивы к умеренному уровню шума, но плохо переносят систематические искажения: дубли, неверные статусы, обрывы цепочек. Подготовка данных нацелена в первую очередь на устранение таких проблем.

3. Кто должен отвечать за данные для ИИ-проектов?

Чаще всего это CDO, Head of Data или руководитель аналитики / BI, который работает вместе с IT и безопасностью. Для маркетинга полезно иметь человека со стороны бизнеса, который берёт на себя постановку задач и использование результатов, а не только обсуждение технологии.

4. Что делать, если часть данных у агентств и подрядчиков?

Нужно согласовать формат и частоту выгрузок, выровнять справочники кампаний и каналов, подключить данные к общему контуру передачи. Чем раньше будут единые правила обмена, тем проще будет масштабировать ИИ-сценарии на разные бренды и подрядчиков.

5. Как совместить требования безопасности с использованием внешних ИИ-сервисов?

Выделите отдельный контур для ИИ, где данные уже обезличены и очищены от лишних персональных полей. Подключайте внешние сервисы через контролируемые интерфейсы, ограничьте доступ к исходным CRM-таблицам и фиксируйте, какие именно данные участвуют в запросах.

6. Стоит ли строить свою платформу или использовать готовое решение вроде CyberBrain?

Собственная платформа даёт гибкость, но требует ресурсов на разработку и поддержку. Специализированное решение закрывает типовые задачи по сбору, подготовке, атрибуции и оптимизации и позволяет команде сосредоточиться на бизнес-задачах.

7. Какие изменения нужны в процессах, помимо работы с данными?

Нужны правила использования отчётов и моделей: какие показатели считаются опорными, какие витрины — основой для отчётности, как учитываются рекомендации оптимизатора в медиаплане. Без этого даже хорошо выстроенный слой данных и ИИ-инструменты останутся инициативой отдельных команд, а не частью управленческой практики.

Итоги и что делать дальше

- Без подготовки данных ИИ-проекты в маркетинге редко дают стабильный эффект и быстро теряют доверие.

- Основные шаги:

- выбрать 1-2 приоритетных ИИ-сценария и связанные с ними метрики

- сделать ревизию источников и выбрать опорные системы

- выровнять справочники и идентификаторы

- очистить и объединить данные для этих сценариев

- построить витрины и настроить мониторинг качества

- решить вопросы безопасности и доступа

- Платформа CyberBrain помогает пройти этот путь быстрее за счёт готовых модулей для сбора данных, их подготовки, атрибуции и оптимизации.

Если внутри компании уже возник запрос на переход от разрозненных отчётов к устойчивому слою данных и управляемым ИИ-инструментам, давайте обсудим текущую архитектуру и тот сценарий, с которого вы планируете запускать изменения: hello@cybrain.io

И не забывайте подписаться на наш TG, где мы активно обсуждаем ИИ, делимся реально полезными промптами и гайдами для оптимизации работы: t.me/cyberbrainio — будем на связи!